Vorwort

Bitte beachten Sie, dass das RRZK bzw. der RRZK-Helpdesk zur Aufbewahrung von Passwörtern mit KeePassXC keinen Support leisten kann. Die Verwendung von KeePassXC stellt keine Nutzungsempfehlung des RRZK dar, sondern die folgenden Ausführungen sind lediglich als persönlicher Erfahrungsbericht zu verstehen.

Warum ein Passwortmanager?

Durch immer neue Arten von Trojanern, Sicherheitslecks und Datendiebstahl wird die Bedeutung von Passwörtern und der Umgang damit immer wichtiger. Schaut man sich die beliebtesten Passwörter des Jahres 2018[1] an, so wird verständlich, wieso auch ohne tiefgreifendes IT-Knowhow ein Account durch Raten und Ausprobieren vergleichsweise einfach zu „hacken“ ist.

Dabei geht es nicht nur um die Einfachheit und Beliebtheit eines Passworts, sondern auch um dessen gleichzeitige Verwendung für mehrere Dienste: Mit einer E-Mail-Adresse/einem bekannten Benutzernamen und einem erratenen oder gehackten Passwort gelangen Kriminelle so bspw. nicht nur an ein E-Mailpostfach, sondern ebenfalls an die Anmeldedaten für Netflix, das Online-Banking und das Online-Portal der Krankenkasse. Die mittlerweile allseits bekannte Schlussfolgerung ist naheliegend: Für jeden Dienst sollte ein unterschiedliches und darüber hinaus ausreichend sicheres Passwort gewählt werden. Dies ist auch die offizielle Empfehlung des Bundesamtes für Sicherheit in der Informationstechnik (BSI). Seine bisherige Empfehlung Passwörter regelmäßig zu ändern, hat das BSI inzwischen zurückgenommen.

In Zeiten, in denen viele Menschen dutzende verschiedene Dienste im Internet benutzen, wird es jedoch immer schwieriger, sich alle Zugangsdaten zu merken bzw. diese verlässlich zu speichern. Das Anlegen einer Liste mit Passwörtern in einem Word- oder Exceldokument eignet sich aufgrund der fehlenden bzw. unzureichenden Verschlüsselungsmöglichkeiten ebenso nicht wie bei allen anderen Methoden, bei denen der Zugriff nicht ausreichend geschützt werden kann. Ein klassisches Notizbuch mit handschriftlich notierten Passwörtern scheidet ebenfalls aus, denn bei Verlust sind nicht nur alle Zugangsdaten weg, sondern können unter Umständen sogar in fremde Hände gelangen.

Es bietet sich daher an, einen der zahlreichen Passwortmanager zu verwenden, die es mittlerweile gibt. Ein Passwortmanager ist ein Programm bzw. eine Datenbank, in der die Zugangsdaten für unendlich viele Dienste verschlüsselt und damit sicher gespeichert werden können. In der Grundfunktion wird diese Datenbank mit einem Master-Passwort gesichert, welches im Anschluss das einzige ist, das sich die Nutzer*innen für den Zugang zur Passwortdatenbank merken bzw. aufbewahren müssen. Falls dieses Passwort jemals vergessen sollte, ist der Zugang auf die Datenbank unwiederbringlich verloren und der Zugriff auf die gespeicherten Zugangsdaten somit für immer verschlossen. Es bietet sich daher an, das Passwort einem sicheren Ort, z.B. einem Safe oder einem Bankschließfach, aufzubewahren.

In diesem Artikel soll das Programm „KeePassXC“ vorgestellt werden. Bei zahlreichen unabhängigen Tests zählte es bislang zu den am besten bewerteten Passwortmanagern und ist darüber hinaus als Open-Source-Software kostenlos. Zudem ist es für die gängigsten Betriebssysteme (Windows, Linux und macOS; für Android und iOS gibt kompatible Programme) verfügbar.

Bitte lassen Sie nicht verwirren lassen: Unter dem Namen KeePass gibt es mittlerweile zahlreiche unterschiedliche Versionen, so zum Beispiel KeePassX oder KeePass2. Die hier vorgestellte Version KeePassXC[2] ist im Gegensatz zu den anderen Versionen unter Windows, Linux und macOS nutzbar und hat viele sinnvolle und bereits integrierte Features, welche in den anderen Versionen händisch nachinstalliert werden müssen.

Speicherort der Datenbank

Wie schon erläutert werden die Zugangsdaten im Passwortmanager in einer verschlüsselten Datenbank gespeichert. Wählen Sie als Speicherort für diese Datenbank die lokale Festplatte, bietet dies zunächst keinen größeren Mehrwert. Denn sobald Sie den Computer nicht bei sich haben, können Sie unterwegs auch nicht auf die Zugangsdaten zugreifen. Auch wenn Sie die Passwortdatenbank auf ihrem Handy mit sich tragen würden, könnte sie bei Verlust des Handys verloren gehen. Es bietet sich daher an, die Passwort-Datenbank in einer Cloud abzuspeichern. Somit können Sie nicht nur von überall auf Ihre Passwörter zugreifen, Sie müssen sich auch keine Gedanken über ein Backup Ihrer Passwort-Datenbank machen. Als Angehörige/r der Universität zu Köln können Sie hierzu sciebo[3] verwenden. Im Gegensatz zu den anderen gängigen Cloud-Diensten wie bspw. iCloud, OneDrive, Dropbox befinden sich Ihre Daten auf einem von der WWU Münster verwalteten und DGSVO-konformen Server in NRW.

Einrichtung von KeePassXC

Im Folgenden wird die Einrichtung von KeePassXC und sciebo beschrieben. Die Anleitung[4] orientiert sich dabei an der Windows-Version, gilt aber ebenso mit minimalen Abweichungen für Linux und MacOS.

- Installieren Sie zunächst den sciebo-Client[5] und richten diesen mit Ihrem sciebo-Account ein.

- Laden Sie KeePassXC von der Internetseite[6] für Ihr jeweiliges Betriebssystem herunter und installieren Sie es anschließend (mit den Standardvoreinstellungen). Alternativ ist auch die Nutzung einer Portable-Version möglich, welche Sie nicht installieren müssen.

- Klicken Sie nun auf „Neue Datenbank erstellen“ (oder alternativ im Menü unter „Datenbank“ auf „Neue Datenbank“).

- Vergeben Sie nun einen Namen für Ihre Passwort-Datenbank („Datenbankname“). Optional können Sie noch eine Beschreibung hinzufügen.

- Lassen Sie bei den „Verschlüsselungseinstellungen“ die Werte unverändert und klicken auf „weiter“.

- Vergeben Sie nun bei „Datenbank-Anmeldedaten“ ein neues Master-Passwort, welches besonders sicher sein sollte. Verwenden Sie eine hinreichende Anzahl der Zeichen, Groß- und Kleinschreibung sowie Ziffern und Sonderzeichen. Folgen Sie hierfür bspw. den Hinweisen des Bundesamtes für Sicherheit in der Informationstechnik BSI https://www.bsi-fuer-buerger.de/BSIFB/DE/Empfehlungen/Passwoerter/passwoerter_node.html.

Wie bereits erwähnt: Wenn Sie das Master-Passwort jemals vergessen sollten, ist der Zugriff auf Ihre Passwörter unwiederbringlich verloren!

Durch Klick auf das Würfel-Symbol erhalten Sie alternativ auch die Möglichkeit, sich ein sicheres Passwort per Zufall generieren zu lassen.

Sollten Sie einen Yubikey[7] besitzen, haben Sie sogar die Möglichkeit, ein sehr langes, mit vielen Sonderzeichen versehenes und „nicht sprechendes“ Passwort nicht händisch eingeben zu müssen, sondern dies per Knopfdruck den Yubikey erledigen lassen (folgen Sie hierfür der Anleitung „Static Password Mode“[8]).

- Über „Zusätzlichen Schutz hinzufügen“ können Sie die Datenbank zusätzlich zum Passwort noch durch weitere Sicherheitsmechanismen schützen, siehe Exkurs „zusätzlicher Schutz“.

- Nach Klick auf „Fertig“ ist Ihre Datenbank erstellt und Sie müssen diese noch abspeichern. Wählen Sie als Dateispeicherort nun einen Ordner aus, der von sciebo synchronisiert wird. Damit wird Ihre Datenbank auf allen Endgeräten sowie auf dem sciebo-Server auf dem aktuellen Stand gehalten.[9]

- Nun können Sie die Datenbank mit Einträgen befüllen und Ihre Zugangsdaten eintragen. Durch das Anlegen von „Gruppen“ können Sie diese thematisch gliedern.

Sobald Ihre Datenbankdatei per sciebo synchronisiert wurde, können Sie auf diese auch von anderen Computern/Endgeräten zugreifen. Für Windows, MacOS und Linux gilt: Installieren Sie hierzu jeweils zunächst den sciebo-Client sowie KeePassXC.

Exkurs: „zusätzlicher Schutz“

Es ist festzuhalten, dass Sie den Zugang zu Ihren Passwörtern bislang zweifach gesichert haben: mit den Zugangsdaten zu sciebo sowie durch das Datenbank-Master-Passwort. Falls Sie also in KeePassXC die Datenbank noch zusätzlich mit einem Sicherheitsmechanismus versehen, erhöht sich die Zahl der Schranken auf drei (oder gar vier). Ob Sie die Passwortdatenbank zusätzlich–schützen sollten, hängt von Ihrem eigenen Schutzbedürfnis ab, ggf. auch von den zu speichernden Zugangsdaten in Ihrer Datenbank. Sie haben hierzu verschiedene Alternativen, die Nutzung einer Schlüsseldatei oder eines Yubikeys.

- Durch das Generieren einer „Schlüsseldatei“ erhalten Sie eine Datei, welche fortwährend zusätzlich zur Eingabe eines Passworts für das Öffnen der Datenbank erforderlich ist. Beim Erstellen der Datei wird ein Zahlencode erzeugt, der ein Unikat darstellt bzw. nahezu unmöglich zu erraten ist. Stellen Sie sich die Schlüsseldatei einfach wie eine Schlüsselkarte vor, wie sie bspw. zum Öffnen der Zimmertür in Hotels heutzutage üblich ist. Immer wenn Sie das Passwort zum Öffnen der Datenbank eingeben, müssen Sie parallel auch die Schlüsseldatei vorzeigen. Dementsprechend müssen Sie diese immerzu „mit dabei haben“, falls Sie die Datenbank unterwegs öffnen möchten.

Damit stellt sich die Frage, wo die Schlüsseldatei aufbewahrt werden kann:

- Falls Sie ausschließlich Desktop-Computer oder Laptops verwenden, bietet es sich an, die Datei auf einen USB-Stick zu speichern, den Sie immer mit sich herumtragen (bspw. am Schlüsselbund, im Geldbeutel). Die Schlüsseldatei befindet sich somit nie dauerhaft auf einem der Computer selbst. Auf mobilen Endgeräten kann der USB-Stick jedoch nicht verwendet werden.

- Sie können die Schlüsseldatei auch direkt auf die entsprechenden Endgeräte kopieren. Sie ist dann aber einer potentiellen Gefahr ausgesetzt, wenn sich jemand Zugriff auf das mobile Endgerät verschafft. Durch Verschlüsselung des Datenträgers sowie durch das Einrichten eines Zugriffsschutz in Form eines Passworts (Windows, MacOS, Linux), einer PIN oder eines Fingerabdrucks usw. (Android, iOS) kann dieses Risiko wiederum minimiert werden.

Falls jemand Unerwünschtes in Besitz der Schlüsseldatei kommen sollte, sei bemerkt, dass diese ohne das Passwort und ohne Zugriff auf die Datenbank (die Cloud) wertlos ist. Wie beim Passwort gilt, dass die Schlüsseldatei bei Verlust nicht wiederhergestellt werden kann; der Zugriff auf die Datenbank wäre – auch mit dem richtigen Passwort – unwiderruflich verloren. Es bietet sich daher erneut an, die Schlüsseldatei bspw. auf einem (zweiten) USB-Stick zu Hause sicher zu verwahren.

Um eine Schlüsseldatei zu verwenden und zu erstellen, folgen Sie der obigen Anleitung unter Punkt 7 und klicken dort auf „Schlüsseldatei hinzufügen“. Wählen Sie dabei mit „Durchsuchen“ den Pfad aus, unter der die Schlüsseldatei nach dem Erstellen abgelegt werden soll und von wo Sie diesen

- Mit Hilfe eines „Yubikeys“ können Sie Ihre Datenbank zusätzlich zu einem Passwort (und zu einer Schlüsseldatei) per sog. „challenge response“ absichern. Eine Anleitung findet sich hier[10]. Ähnlich wie bei einer Schlüsseldatei müssen Sie diesen immer dabeihaben, um Ihre Datenbank zu öffnen. Dieser Sicherungsmechanismus ist nur fortgeschrittenen Userinnen und Usern empfohlen. Zudem ist im Einzelfall zu prüfen, wie der Yubikey unter Android und iOS zum Einsatz kommen kann.

Nutzung unter iOS und Android

Für iOS und Android gibt es keine KeePassXC-Version; hier ist auf andere Apps zurückzugreifen: für iOS die App „Strongbox“[11] (erhältlich im AppStore), für Android die App „Keepass2Android“[12] (zu beziehen über den PlayStore). Da die Benutzung dieser Apps sich betriebssystembedingt etwas von den Desktop-Versionen unterscheidet, soll hier kurz auf diese eingegangen werden.

iOS

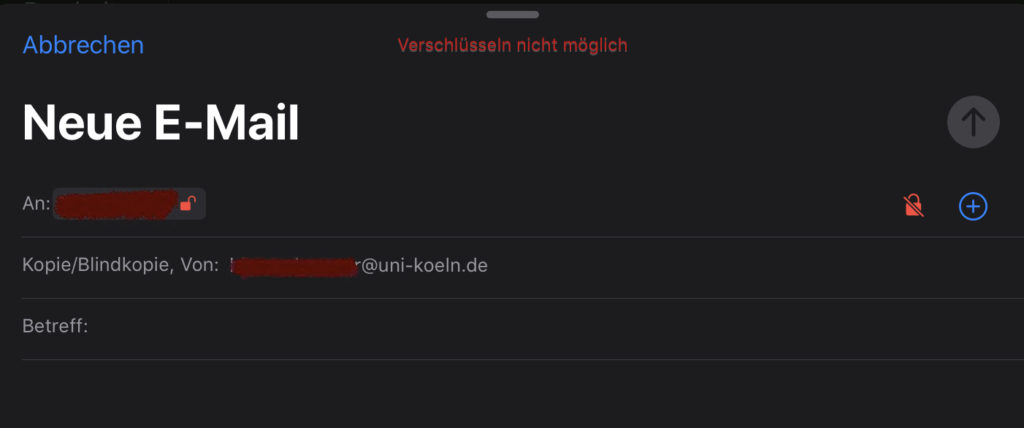

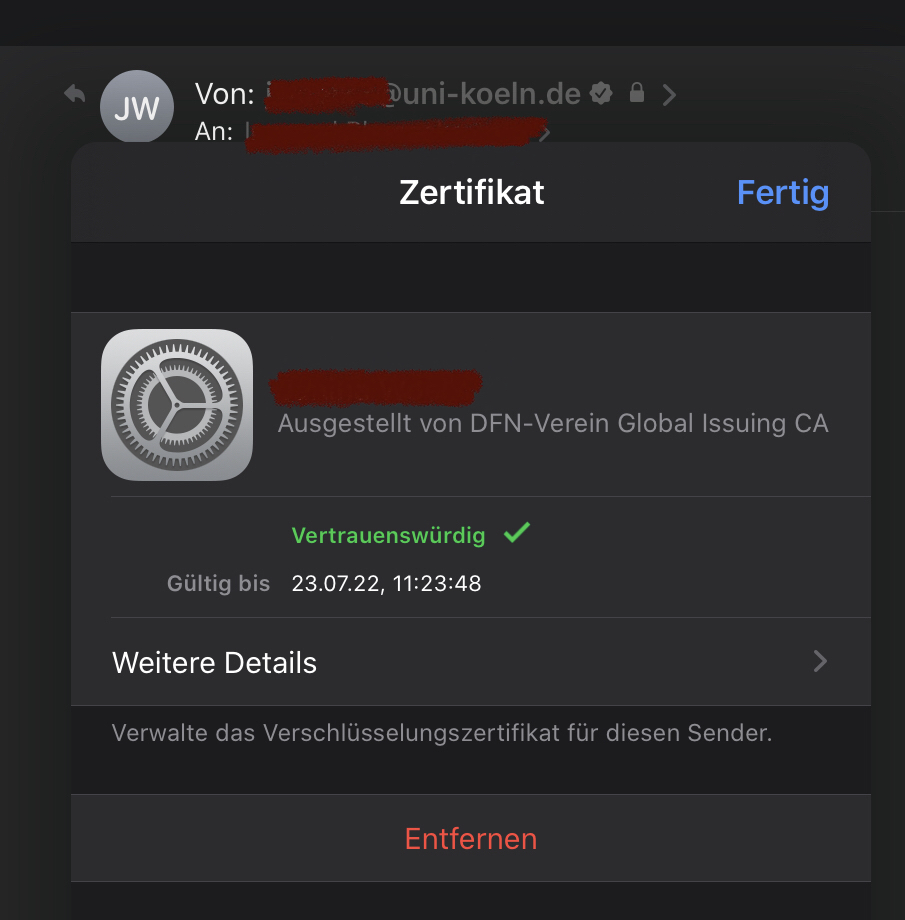

Installieren Sie die Apps „Strongbox“ sowie „sciebo“ und richten Sie letzteres ein. Öffnen Sie die App „Strongbox“ und klicken rechts oben auf das Plus-Symbol. Wählen Sie dort „Vorhandene hinzufügen…“. In der angezeigten Liste klicken Sie auf „WebDAV“. Geben Sie bei Verzeichnis die URL „https://uni-koeln.sciebo.de/remote.php/webdav“, bei „Benutzername“ Ihren sciebo-Benutzernamen (Achtung: Vergessen Sie nicht den Zusatz „@uni-koeln.de“ nach Ihrem Personal-Accountnamen!) sowie Ihr dazugehöriges Passwort ein. Wählen Sie im Anschluss den Pfad zu Ihrer Datenbank-Datei (die Datei hat die Endung „.kdbx“). Sie können nun den Namen der zu öffnenden Datenbank verändern oder per „Hinzufügen“ bestätigen. Klicken Sie nun auf den neu erstellten Eintrag in der Datenbankliste. Dort müssen Sie das Passwort Ihrer Datenbank eingeben und ggf. die Schlüsseldatei „Auswählen“.

Android

Installieren Sie die Apps „Keepass2Android“ und „sciebo“. Öffnen Sie diese und wählen „Datei öffnen“ sowie anschließend „ownCloud“. Geben Sie bei im obersten Feld („ownCloud-URL“) „uni-koeln.sciebo.de“, bei „Benutzername“ Ihren sciebo-Benutzernamen (Achtung: Vergessen Sie nicht den Zusatz „@uni-koeln.de“ nach Ihrem Personal-Accountnamen!) sowie Ihr dazugehöriges Passwort ein. Wählen Sie im Anschluss den Pfad zu Ihrer Datenbank-Datei (die Datei hat die Endung „.kdbx“). Im folgenden Fenster müssen Sie nun den Schutz der Datenbank auswählen: Wählen Sie bspw. „Nur Kennwort“ oder „Kennwort + Schlüsseldatei“. Geben Sie nun Ihr (Master-)Kennwort Ihrer Datenbank ein und wählen ganz unten „Entsperren“.

[1] https://hpi.de/pressemitteilungen/2018/die-top-ten-deutscher-passwoerter.html

[4] Eine sehr ausführliche Anleitung, in der alle Funktionen und Details beschrieben werden, finden Sie unter https://keepassxc.org/docs/KeePassXC_GettingStarted.html#_welcome.

[5] https://hochschulcloud.nrw/de/download/index.html

[6] https://keepassxc.org/download/

[7] Ein Yubikey ist Security-Token mit vielen verschiedenen Funktionen in Hardwareform, der wie ein kleiner USB-Stick aussieht und bspw. am Schlüsselbund oder im Geldbeutel mit sich geführt werden kann, siehe https://www.yubico.com/der-yubikey/?lang=de.

[8] https://keepass.info/help/kb/yubikey.html

[9] Alternativ ist es auch möglich, sciebo per WebDAV-Protokoll als Laufwerk im Windows-Explorer zu verbinden. Die hierfür zu verwendende URL lautet: https://uni-koeln.sciebo.de/remote.php/webdav/.

[10] https://keepassxc.org/docs/#faq-yubikey-howto

[11] https://apps.apple.com/us/app/strongbox-password-safe/id897283731

[12] https://play.google.com/store/apps/details?id=keepass2android.keepass2android